-

Prochaine date : 27 Avr 2024 15 h 00 min

Cycle de Séminaires organisé par la Revue Multitudes et la Fondation Lucien Paye

(dans les locaux de la Fondation Lucien Paye - Cité universitaire – 45b bd Jourdan – 75014 Paris)

La Revue Multitudes, en coopération avec la Fondation Lucien Paye, veut ouvrir les portes de ses débats sur les grands thèmes d’actualité. L’idée est, d’une part, de faire un bilan des différents dossiers (Majeures et Mineures), souvent précurseurs, produits au long des 25 années d’existence de la revue ; d’autre part, mobiliser des points de vue externes à la revue. L’urgence de ces échanges de perspectives se trouve dans l’accélération de crises croisées dont il est difficile de saisir les termes et encore plus incertain de définir les développements futurs.

Alors que les années 2010 étaient marquées par des épuisements structurels comme la crise financière, les printemps arabes (et les occupy) et l’anthropocène, les années 2020 superposent en très peu de temps la pandémie, la multiplication d’événements extrêmes (liés au climat) et maintenant la guerre de grande échelle. Le pari est de réussir à traverser les différentes crises sans se laisser écraser par leur précipitation, en multipliant les efforts pour y voir les bifurcations et les horizons du possible. Ce que le séminaire veut baliser ce sont donc des questions, des énigmes, des blocages. Ainsi, nous avons décidé d’organiser le premier cycle (2024) de discussions autour de trois blocs transversaux à l’ensemble de ces nouvelles tensions : (1) « Des bons usages du décolonial » ; (2) « Écologie, je t’aime moi non plus ; (3) « L’IA est-elle plus artificielle qu’intelligente ? ».

Premier Bloc: Des bons usages du décolonial

Séance n. 1 - 27 avril 2024 / 15:00

Pierre Singaravélou (Paris 1- Panthéon -Sorbonne)

Autour de Colonisations. Notre histoire : une discussion interdisciplinaire

Maëline Le Lay (CNRS)

Pour une archéologie des discours sur l'Afrique et un déplacement du centre chez VY Mudimbe et Ngugi wa Thiong'o. Deux propositions décoloniales.

Télécharger le programme

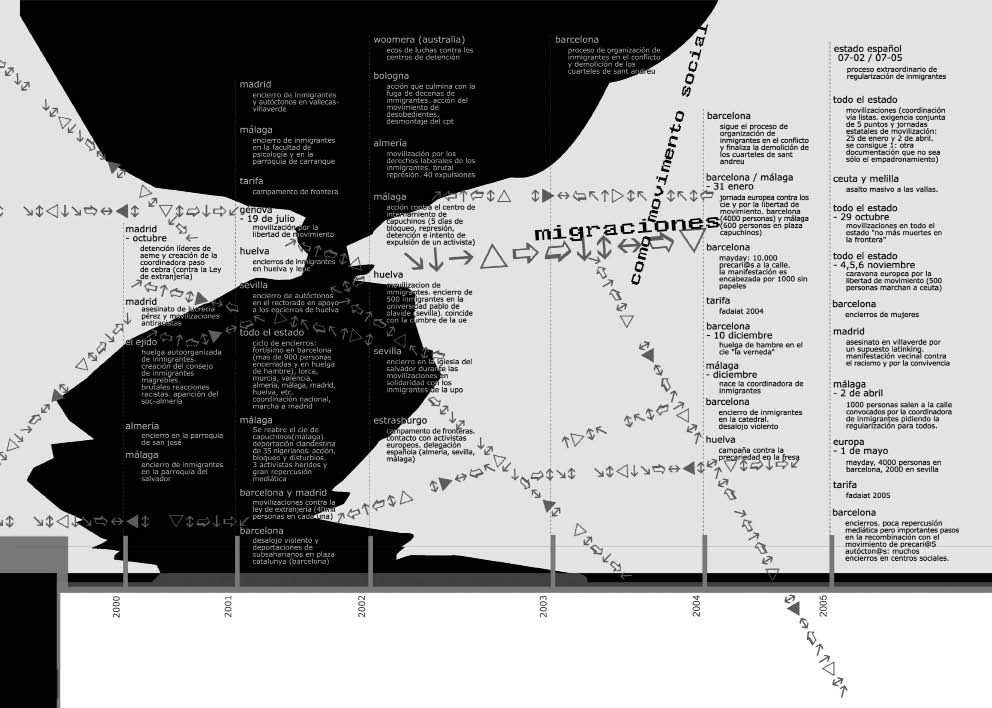

Migrations, l’étoile noire de l’Europe

Dans les années 1970-75, la tache sur la démocratie américaine avait été cette petite fille à demi-nue hurlant dans les flammes de napalm sur une route du Vietnam. En 2015, la tache sur le drapeau européen, c’est le corps de ce petit garçon de trois ans échoué sur la plage turque de Bodrum. Avec sa mère et son frère ils espéraient gagner l’île de Kos pour échapper à l’enfer syrien. Des années plus tard, ce sont ces hommes gelés dans la neige, à la frontière du Bélarus et de la Pologne que la Russie avait obligeamment convoyés.

Les dernières parutions

- Actualité

- À lire en ligne

- Actualité

- À lire en ligne

Navalny : Les assassins, par André Marlowicz

Nous reproduisons la réaction suivante de André Markowicz publiée sur son site facebook